langchain-chatchat langchain chatchat chatglm

langchain

对超长文本进行总结 假如我们想要用 openai api 对一个段文本进行总结,我们通常的做法就是直接发给 api 让他总结。但是如果文本超过了 api 最大的 token 限制就会报错。这时,我们一般会进行对文章进行分段,比如通过 tiktoken 计算并分割,然后将各段发送给 api 进行总结, ......

教你如何基于MindSpore进行ChatGLM微调

本文分享自华为云社区《基于MindSpore的ChatGLM微调》,作者: JeffDing 。 基于MindSpore的ChatGLM微调 克隆Hugging Face模型 克隆chatglm-6b代码仓,下载分布式的模型文件 git lfs install git clone https://h ......

基于 P-Tuning v2 进行 ChatGLM2-6B 微调实践

微调类型简介 1. SFT监督微调:适用于在源任务中具有较高性能的模型进行微调,学习率较小。常见任务包括中文实体识别、语言模型训练、UIE模型微调。优点是可以快速适应目标任务,但缺点是可能需要较长的训练时间和大量数据。 2. LoRA微调:通过高阶矩阵秩的分解减少微调参数量,不改变预训练模型参数,新 ......

【开源】给ChatGLM写个,Java对接的SDK

作者:小傅哥 - 百度搜 小傅哥bugstack 博客:bugstack.cn 沉淀、分享、成长,让自己和他人都能有所收获!😄 大家好,我是技术UP主小傅哥。 清华大学计算机系的超大规模训练模型 ChatGLM-130B 使用效果非常牛,所以我也想把这样的Ai能力接入到自己的应用中或者做一些 In ......

Langchain-Chatchat项目:1.1-ChatGLM2项目整体介绍

ChatGLM2-6B是开源中英双语对话模型ChatGLM-6B的第2代版本,引入新的特性包括更长的上下文(基于FlashAttention技术,将基座模型的上下文长度由ChatGLM-6B的2K扩展到了32K,并在对话阶段使用8K的上下文长度训练);更高效的推理(基于Multi-QueryAtte ......

Langchain-Chatchat项目:1-整体介绍

基于Langchain与ChatGLM等语言模型的本地知识库问答应用实现。项目中默认LLM模型改为THUDM/chatglm2-6b[2],默认Embedding模型改为moka-ai/m3e-base[3]。 一.项目介绍 1.实现原理 本项目实现原理如下图所示,过程包括加载文件->读取文本->文 ......

Langchain-Chatchat项目:3-Langchain计算器工具Agent思路和实现

本文主要讨论Langchain-Chatchat项目中自定义Agent问答的思路和实现。以"计算器工具"为例,简单理解就是通过LLM识别应该使用的工具类型,然后交给相应的工具(也是LLM模型)来解决问题。一个LLM模型可以充当不同的角色,要把结构化的Prompt模板写好,充分利用LLM的Zero/O ......

Langchain-Chatchat项目:1.2-Baichuan2项目整体介绍

由百川智能推出的新一代开源大语言模型,采用2.6万亿Tokens的高质量语料训练,在多个权威的中文、英文和多语言的通用、领域benchmark上取得同尺寸最佳的效果,发布包含有7B、13B的Base和经过PPO训练的Chat版本,并提供了Chat版本的4bits量化。 一.Baichuan2模型 B ......

Langchain-Chatchat项目:2.1-通过GPT2模型来检索NebulaGraph

在官方例子中给出了通过chain = NebulaGraphQAChain.from_llm(ChatOpenAI(temperature=0), graph=graph, verbose=True)来检索NebulaGraph图数据库。本文介绍了通过GPT2替换ChatOpenAI的思路和实现,暂 ......

GPT之路(九) LangChain - Memory

记忆封装 - Memory (langchain memory) Memory:这里不是物理内存,从文本的角度,可以理解为“上文”、“历史记录”或者说“记忆力”的管理 ConversationBufferMemory可也用来保留会话信息 In [ ]: from langchain.memory i ......

Llama2-Chinese项目:7-外延能力LangChain集成

本文介绍了Llama2模型集成LangChain框架的具体实现,这样可更方便地基于Llama2开发文档检索、问答机器人和智能体应用等。 1.调用Llama2类 针对LangChain[1]框架封装的Llama2 LLM类见examples/llama2_for_langchain.py,调用代码如下 ......

文章《Semantic Kernel -- LangChain 的替代品?》的错误和疑问 探讨

微信公众号文章 Semantic Kernel —— LangChain 的替代品?[1] ,它使用的示例代码是Python ,他却发了这么一个疑问:支持的语言对比(因为 Semantic Kernel 是用 C#开发的,所以它对 C#比较支持)如上所示。不清楚 Semantic Kernel 为什 ......

ChatGLM2

下载chatglm2-6b print('开始加载分词器tokenizer...') tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm2-6b", trust_remote_code=True) print('开始加载语言模型model ......

ChatGLM-6B-PT微调

目录开发环境ChatGLM2-6B源码下载模型安装依赖下载ADGEN数据集微调前修改训练步数微调后 开发环境 矩池云 https://www.matpool.com/host-market/gpu ChatGLM2-6B源码 https://github.com/THUDM/ChatGLM2-6B ......

使用Triton部署chatglm2-6b模型

一、技术介绍 NVIDIA Triton Inference Server是一个针对CPU和GPU进行优化的云端和推理的解决方案。 支持的模型类型包括TensorRT、TensorFlow、PyTorch(meta-llama/Llama-2-7b)、Python(chatglm)、ONNX Run ......

本地部署 Langchain-Chatchat & ChatGLM

一、模型&环境介绍 1. ChatGLM github 地址:https://github.com/THUDM 模型地址:https://huggingface.co/THUDM 2. m3e 模型地址:https://huggingface.co/moka-ai/m3e-base/ 3. text ......

LangChain使用fine-tuned GPT-3.5

LangChain使用fine-tuned GPT-3.5 参考: https://openai.com/blog/gpt-3-5-turbo-fine-tuning-and-api-updates https://platform.openai.com/docs/guides/fine-tunin ......

16G内存+CPU本地部署ChatGLM2/Baichuan2推理(Windows/Mac/Linux)

概述 本文使用chatglm.cpp对中文大语言模型(LLM)进行量化与推理,支持ChatGLM2-6B、Baichuan2-13B-Chat等模型在CPU环境16G内存的个人电脑上部署,实现类似ChatGPT的聊天功能。支持的操作系统包括Windows、Mac OS、Linux等。 其中,量化过程 ......

解决 ChatGLM.CPP+clBlast 编译错误(也适用于SD.CPP)

首先安装 OpenCL 和 clblast: vcpkg install opencl clblast 下载GitHub 上的源码: git clone --recurse-submodules https://github.com/li-plus/chatglm.cpp cd chatglm.cp ......

GPT之路(八) LangChain - Models入门

环境:Python 3.11.4, LangChain 0.0.270, Jupyter Models模型简介 官方地址:LangChian - Models Langchain所封装的模型分为两类: 大语言模型 (LLM) 聊天模型 (Chat Models) Langchain的支持众多模型供应 ......

安装langchain-chatchat

1、下载langchain-chatchat git clone https://github.com/chatchat-space/Langchain-Chatchat.git 2、下载llama2-7b-chat-hf git lfs installgit clone https://huggi ......

Javascript版Langchain入门

https://baijiahao.baidu.com/s?id=1769509377621631060&wfr=spider&for=pc 介绍 LangChain是一个开源Python库,用于构建由大型语言模型(LLM)支持的应用程序。它提供了一个框架,将LLM与其他数据源(如互联网或个人文件) ......

Langchain的一些问题和替代选择

Langchain因其简化大型语言模型(llm)的交互方面的到关注。凭借其高级的API可以简化将llm集成到各种应用程序中的过程。 但是Langchain乍一看似乎是一个方便的工具,但是它有时候否更像是一个语言迷宫,而不是一个直截了当的解决方案。在本文中,我们将探讨与Langchain相关的一些问题 ......

GPT之路(七) LangChain AI编成框架入门的第一个demo

环境:Python 3.11.4, LangChain 0.0.270 1.Langchain 简介 1.1 Python Langchain官方文档 大型语言模型(LLM)正在成为一种具有变革性的技术,使开发人员能够构建以前无法实现的应用程序。然而,仅仅依靠LLM还不足以创建一个真正强大的应用程序 ......

chatglm2-6b在P40上做LORA微调

目前,大模型的技术应用已经遍地开花。最快的应用方式无非是利用自有垂直领域的数据进行模型微调。chatglm2-6b在国内开源的大模型上,效果比较突出。本文章分享的内容是用chatglm2-6b模型在集团EA的P40机器上进行垂直领域的LORA微调。 ......

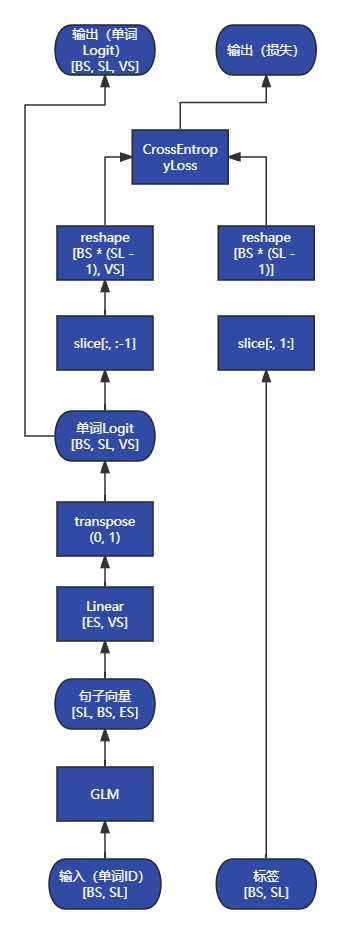

ChatGLM2 源码解析:`ChatGLMForConditionalGeneration.forward`

```py class ChatGLMForConditionalGeneration(ChatGLMPreTr ......

ChatGLM2 源码解析:`ChatGLMModel`

```py # 完整的 GLM 模型,包括嵌入层、编码器、输出层 class ChatGLMModel(ChatG ......

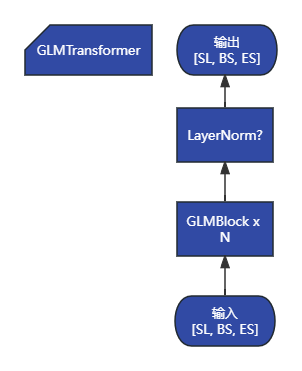

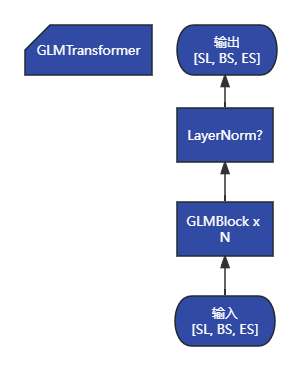

ChatGLM2 源码解析:`GLMTransformer`

```py # 编码器模块,包含所有 GLM 块 class GLMTransformer(torch.nn.Mo ......

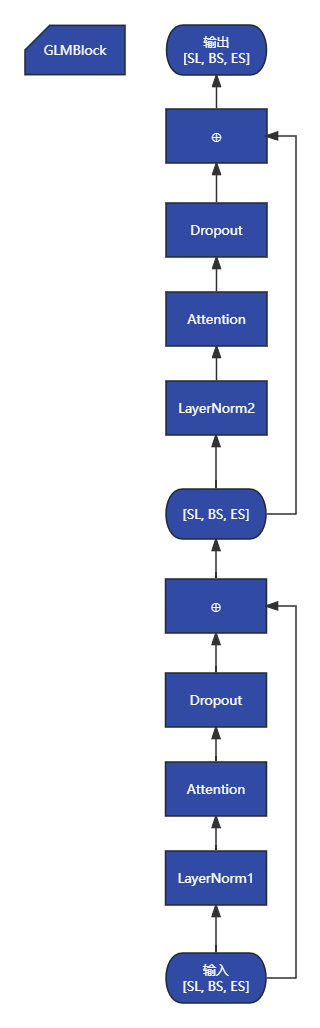

ChatGLM2 源码解析:`GLMBlock`

```py # GLM 块包括注意力层、FFN层和之间的残差 class GLMBlock(torch.nn.Mo ......

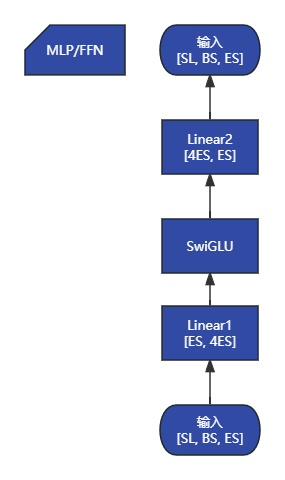

ChatGLM2 源码解析:`MLP`

```py class MLP(torch.nn.Module): """MLP. MLP will take ......